|

AI 不是一个新的概念,它的发展经历了六十多年,在这六十年里,人工智能的发展之路并不平坦。在去年人工智能又突然爆发了,势头一直延续到了现在。1956 年的达特茅斯会议,AI 这个名词被首次提出。人工智能比较有名的事件是九十年代 IBM 深蓝打败了卡斯帕罗夫,也就是那个时代的 AlphaGo 和李世乭。人们记忆中最清晰的一件事还是去年 AlphaGo 围棋打败围棋世界冠军李世乭,这表明在围棋这个最古老、最复杂的游戏上面,AlphaGo 的智能已经超越了人类。

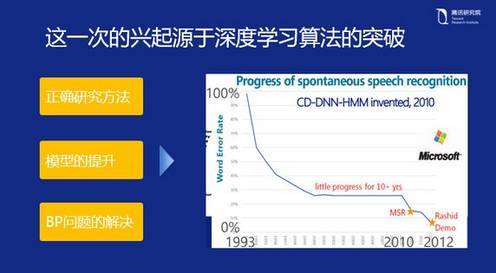

当然整个发展史里面也有很多技术方面的演进,比较有代表性的就是 2006 年,Geoffery Hinton 在深度学习上有了巨大的突破,带领 AI 的所有发展方向极速提升。我认为这次人们期待 AI 最主要的原因是这一次 AI 的底层算法在深度学习上面有了实质性的突破。 这次 AI 的发展是从 2012 年开始的,先在业界落地。可以看到整个深度学习的方法和传统方法完全不一样,不像以前的研究方法,是通过模仿来实现的。这一情形和早期人类想粘上羽毛学习飞翔比较类似,我们都知道真正的飞翔是通过空气动力学去完成的,这也是深度学习的一个思想之一。之所以现在能有很多应用上的突破,是因为研究员们掌握了内在的学习方法,而不是表面的模仿。所以从这一点来说,我们现在在深度学习的研究方法上是正确的。 第二个是模型上的提升,刚才我说了,AI 的发展有六十年,机器学习以及深度学习并不是最近才突然出现的。神经网络早在六十年代就有过——当时提出来感知机(perceptron)。机器学习在八九十年代也非常火,当时有一个叫 SVM(支持向量机)的分类器,已经是非常厉害的一种机器学习的算法。那么现在为什么又重新提出来?深度学习同原来的机器学习相比,在模型能力上有非常大的提升。大家都知道我们所有的机器学习的方法,都是从 A 到 B 去寻找一个拟合函数,实现一个最佳的拟合过程。在这个过程中如果选取的特征越多,拟合的效果就会越好。但同时有一个问题,当特征太多的时候,计算能力就会出现问题。在浅层模型中,如果要模拟出一个从 A 到 B 的完美拟合过程,它的数据能达到几亿甚至几十亿的规模,当他达到这种规模的时候它的计算能力就会急剧下降,会通过一个非常复杂的复合函数去描述数据。但是深度学习的方式能够很好的解决这个问题,它通过深度学习神经网络的多层连接,其特征表达是一个指数层倍的关系,如果说用一个全连接(fully connected)描述十亿的特征,可能我们只需要三层一千个节点的连接,就能构建十亿个特征的权重出来。所以从本质来讲,模型上的提升也是深度学习的一个突破。 另外,针对反向传播问题(BP),AI 界从 80 年代开始真正使用 BP 算法来训练多层神经网络。在神经网络里,当输入信息由多层网络向前传播之后,将网络的输出结果与实际结果的误差,从输出层向输入层反向传播。在整个 BP 过程,都是需要通过随机梯度下降的方式进行求解,以逐渐逼近最优值。今年来,随着网络结构的不断加深,使用传统的 Sigmoid 激活函数使深层网络的参数优化过程中出现梯度消失的问题。通过一些数学的理论和技巧,可以很好解决这种梯度消失问题,以用于训练非常深层的神经网络。

正因为这三方面的优势,使得在这次 AI 的浪潮里,深度学习才会如此之火。而且我坚信这次的 AI 浪潮会持续很久。在 1993 年到 2000 年左右,整个传统的浅层机器学习的研究进展还是很不错的,图中可以看到这段时期错误率有明显的下降,也即识别效果的提升很快。但是从 2000 年到 2010 年这十年,可以看出没有明显的下降变化。可能是在方法上面,在模型上面都没有太大的研究进展。在 2012 年左右有一个明显的转折点,也就是微软研究院第一个在业界把深度学习用于语音识别,取得了极大性的突破,随后又进行了一系列性能上的提升。在过往的五年当中,深度学习的发展是非常快的。 (责任编辑:本港台直播) |