|

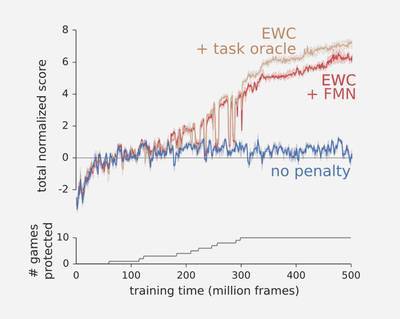

计算机程序学习执行一项任务后,通常会很快忘记它。DeepMind最新研究通过修改学习规则,程序在学习一个新任务时,还能回忆执行过的任务。无疑这能够让程序,能够更加持续地、自适应地学习,是程序迈向更加智能化的重要一步。 深度神经网络是目前用于解决各种任务(包括语言翻译,图像分类和图像生成)的最成功的机器学习技术。但是,计算机程序学习执行一项任务后,通常会很快忘记它。而人类的大脑则以不同的方式工作。我们能够逐步学习,一次获得一个技能,atv,并在学习新任务时运用我们以前的知识。DeepMind在近期发布的PNAS文章里,提出一种方法来克服神经网络中的灾难性遗忘。灵感源自于神经科学的理论知识,关于哺乳动物和人类大脑巩固化既往获得的技能和记忆。 神经科学家已经区分了在大脑中发生的两种巩固方式:系统巩固和突触巩固。系统巩固是通过我们的大脑的快速学习部分获得的记忆被印记到缓慢学习部分的过程。这种印记已知是由有意识的和无意识的回忆所介导的 - 例如,这可能在梦中发生。在第二种机制:突触巩固,在之前学习任务中扮演重要角色的神经元之间的连接不太可能被重写。我们算法的具体灵感,就是从这种机制中找到并落实应用去解决灾难性遗忘问题。 神经网络由几个连接组成,方式与人脑类似。学习任务后,我们会计算每个链接对任务的重要性。当我们学习一个新的任务时,根据他们对旧任务的重要性比例来保护它们,以避免被更改。因此,可以学习新任务而不充血再先前任务重已经学习的内容,并且不会让计算成本显著增加。用数学方式来说:我们可以认为在一个新任务中每个链接所附加的保护与旧保护值相关联。类似弹簧,强度和连接的重要性成比例。为此,我们称之为“弹性权重合并”( Elastic Weight Consolidation , EWC)。 为了测试我们的算法,我们依次让其执行了一个Atari游戏。从单独的分数来学习一个游戏是一项很有挑战性的任务,一次学习多个游戏无疑更具挑战性。因为每个游戏都需要单独的策略。如下图所示,如果没有EWC,程序会在每个游戏停止后(蓝色)快速忘记游戏。这意味着,平均来说,程序几乎没有学习任何一个游戏。然而,如果我们使用EWC(棕色和红色),代理不会轻易忘记,atv,并可以学习玩几个游戏,一个接一个。

今天,计算机程序不能自适应地和实时地从数据中进行学习。然而,DeepMind已经表明灾难性遗忘不是神经网络的不可逾越的挑战。这项研究代表,我们已经向更灵活和更有效方式的学习方案迈出了重要一步。 本次研究也推进了我们对人类大脑中如何去巩固原有知识的理解。事实上,DeepMind的工作所基于的神经科学理论主要在非常简单的例子中得到了证实。 通过将这些理论应用在更现实和复杂的机器学习环境中,DeepMind也给予进一步的重量想法,突触巩固是保留记忆和专门知识的关键,如何加强对突触固化在记忆保留中的作用及其机制是下一步研究的关键问题。 兼职翻译 招聘 《全球人工智能》面向全球招聘多名海外:图像技术、语音技术、自然语言、机器学习、数据挖掘等专业技术领域的兼职翻译,工作内容及待遇请在公众号内回复“兼职+个人微信号”联系工作人员。 热门文章推荐

(责任编辑:本港台直播) |