|

特别地,我们将在 23 节中列举一系列关于强化学习的资源,包括图书、在线课程、教程、会议、期刊、研讨会乃至博客等。如果非要选择唯一一个推荐的强化学习的资源,那么应该是 Sutton 教授的强化学习书(RL Book,Sutton and Barto,2017,第二版正在编辑中)。它覆盖了强化学习的基础知识,并介绍了它最新的进展,包括深度 Q 网络、AlphaGo、梯度策略方法(Policy Gradient Methods)及在心理学与神经科方面的进展。对深度学习而言,则可以选择 Goodfellow 等人的书(2016)。 2 背景知识 在这一节中,我们将会简要介绍在深度学习(Sutton and Barto,2017)与深度学习(Goodfellow et al., 2016)方面的基础知识与概念。 2.1 深度学习 2.2 强化学习 2.3 测试平台 街机学习环境(Arcade Learning Environment,ALE,Bellemare et al., 2013)是一个由 2600 个 Atari 游戏构成的用于研发及评估 AI 的框架。 DeepMind 团队则发布了它的第一人称视角 3D 游戏平台 DeepMind Lab(Beattie et al., 2016)。DeepMind 及暴雪会合作以发布星际争霸 2 的人工智能研究环境(goo.gl/Ptiwfg)。 OpenAI Gym(https://gym.openai.com/)是一个用于开发强化学习算法的工具包。它由一系列环境构成,包括了 Atari 游戏及模拟的机器人构成,以及一个用于比较及复现结果的网站。 OpenAI Universe(https://universe.openai.com/)被用于将任一程序转换到一个 Gym 环境。Universe 已经集成了许多的环境,包括 Atari 游戏、flash 游戏、如 Mini World of Bit Sand 这样的浏览器任务。最近,侠盗猎车手 5(GTA5)也已经被加入到 Universe 中来帮助模拟自动驾驶车辆。 FAIR TorchCraft(Synnaeve et al., 2016)是一个为如星际争霸这样实时战略类(RTS)游戏开发的库。 ViZDoom 是一个基于《毁灭战士(Doom)》游戏的为研究视觉强化学习的研究平台。 TORCS 是一个赛车比赛驾驶模拟器(Bernhard Wymann et al., 2014)。 MuJoCO(Multi-Joint dynamics with Contact)是一个物理引擎,参见: Duan et al., 2016 为连续控制任务给出了一个跑分平台,开源代码参见:https://github.com/openai/rllab Nogueira and Cho(2016)展示了 WebNav 挑战,直播,来测试维基百科链接导航。 3 深度 Q 网络(DEEP Q-NETWORK)

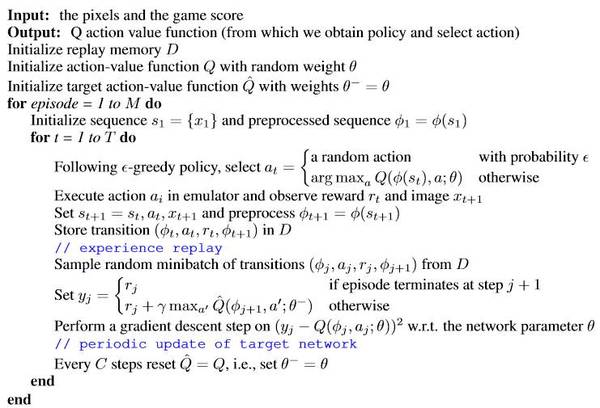

算法 1:深度 Q 网络,截取自 Mnih et al. (2015) 3.1 双重 DQN(DOUBLE DQN) 3.2 优先经验回放(PRIORITIZED EXPERIENCE REPLAY) 3.3 对抗架构(DUELING ARCHITECTURE) 3.4 更多拓展 4 异步方法

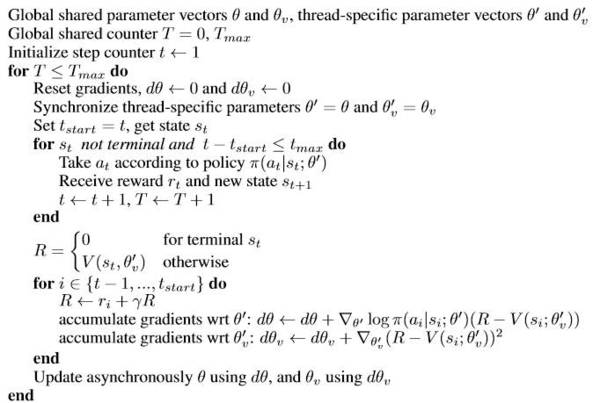

算法 2:A3C,每个 actor-learner 线程,来自 Mnih et al. (2016) 5 策略优化 策略通常是随机的。然而在 2014 年,Silver et al. (2014) 引入确定性策略梯度(DPG)来有效估计策略梯度。Lillicrap et al. (2016) 用深度神经网络扩展了 DPG。同时我们介绍了几份近期成果,包括引导策略搜索(Guided Policy Search,Levine et al.,2016a)、信赖域策略优化(Trust Region Policy Optimization,Schulman et al.,2015)、基准测试结果(Duan et al., 2016)以及策略梯度与 Q 学习(O'Donoghue et al., 2017)。 5.1 确定性策略梯度 5.2 深度确定性策略梯度 5.3 引导策略搜索 5.4 信赖域策略优化 5.5 基准测试结果 Duan et al. (2016) 提出了连续控制任务的基准,包括了一些经典任务(如车柱)、具有极大状态与动作空间的任务(如 3D 人形运动)、部分观察任务、层次结构任务,并实施了许多算法,包括批处理算法:REINFORCE 算法、截断性自然策略梯度(TNPG)、奖励加权回归(RWR)、相对熵策略搜索(REPS)、信赖域策略优化(TRPO)、交叉熵方法(CEM)、自适应协方差矩阵进化策略(CMA-ES); 也包括在线算法:深度确定性策略梯度(DDPG);还有批处理算法的重复性变体。开源地址:https://github.com/openai/rllab (责任编辑:本港台直播) |