|

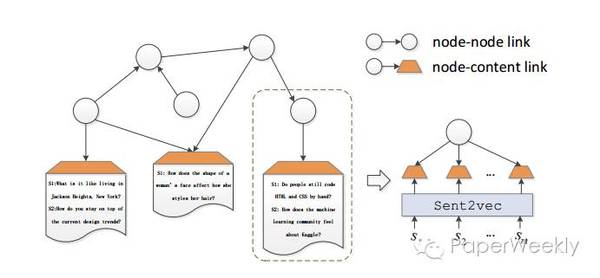

本期的PaperWeekly一共分享四篇最近arXiv上放出的高质量paper,包括:机器翻译、表示学习、推荐系统和聊天机器人。人工智能及其相关研究日新月异,本文将带着大家了解一下以上四个研究方向都有哪些最新进展。四篇paper分别是: 1、A General Framework for Content-enhanced Network Representation Learning, 2016.10 2、Collaborative Recurrent Autoencoder: Recommend while Learning to Fill in the Blanks, 2016.11 3、Dual Learning for Machine Translation, 2016.11 4、Two are Better than One: An Ensemble of Retrieval- and Generation-Based Dialog Systems, 2016.10 A General Framework for Content-enhanced Network Representation Learning作者 Xiaofei Sun, Jiang Guo, Xiao Ding and Ting Liu 单位 Center for Social Computing and Information Retrieval, Harbin Institute of Technology, China 关键词 network representation, content-enhanced 文章来源 arXiv 问题 同时利用网络结构特征和文本特征来学习网络中节点的embedding 模型 总的来说这篇paper的思路比较清晰,学习的方法上很大程度上参考了word2vec的方法。对于一个节点v,将与v相连的节点当做正例,不想连的节点当做负例。那么如何融入内容呢?在网络中设置虚拟的内容节点c,将描述v节点的文本内容c_v当做正例,其他的当做负例c_v’。在优化时同时考虑网络相似性和文本相似性,让v的向量靠近正例远离负例。

总的优化函数如下所示,由两个部分L_nn(节点与节点连接)和L_nc(节点与内容连接)线性组合而成,开奖,alpha越大则考虑网络结构越多文本内容越少。

L_nn和L_nc大体思想如上面所言,两者损失函数一致,尽量接近正例远离反例。但是两者在描述节点概率(相似度)上会有所不同。

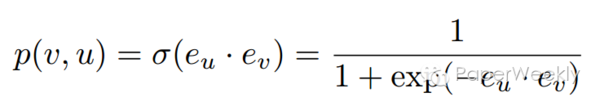

对于节点与节点之间的概率,由于网络结构要考虑有向性,因此将节点的embedding切分成in和out两半,用sigmoid算两个节点的相似度。

节点与内容的概率也是类似,不过内容节点的embedding是固定的,通过额外的文本模型训练出来的。这里尝试的文本model包括word2vec,RNN和BiRNN。

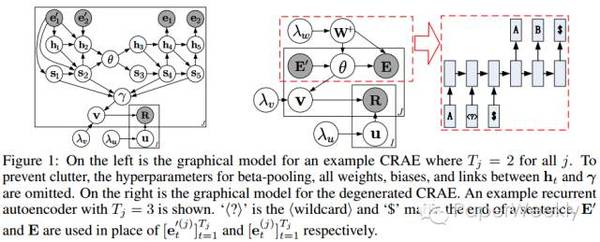

最后在节点分类任务上进行了评测,同时结合网络结构特征和文本特征确实带来了明显的提高。 资源 用到的数据集是DBLP(cn.aminer.org/citation)和自己采集的知乎用户网络。 相关工作 这两年network representation的工作如雨后春笋,在DeepWalk之后有十余篇论文出现。这篇文章在相关工作里有相对全面的覆盖,对这方面工作有兴趣的同学值得参考。 简评 尽管相关模型层出迭见,但略感遗憾的是感觉目前并没有在network embedding之上的较为成功的应用,大多benchmark都是节点分类和链接预测,应用价值有限。十分期待一些更为新颖的benchmark的出现。 Recurrent Autoencoder Recommend while Learning to Fill in the Blanks作者 Hao Wang, Xingjian Shi, Dit-Yan Yeung 单位 HKUST 关键词 Recommendation, Collaborative Filtering, RNN 文章来源 Arxiv, to appear at NIPS’16 问题 本文的主要贡献是提出collaborative recurrent autoencoder (CRAE),将CF (collaborative filtering)跟RNN结合在一起,提高推荐的准确率,并且可以用于sequence generation task。 模型 传统的LSTM模型没有考虑进噪声,对不足的训练数据稳定性不好,文章提出RRN (robust recurrent networks),为RNN的加噪版本,RRN中的噪声直接在网络中向前或者向后传播,不需要分开的网络来估计latent variables的分布,更容易实现且效率高。CARE的模型如下图所示,序列处理的信息保存在cell state s_t和输出状态h_t中,两个RRN可以组合形成编码译码结构。

|