|

技术顾问:赵巍、Yuxi Li 近日,百度将 Deep CNN 应用于语音识别研究,使用了 VGGNet ,以及包含 Residual 连接的深层 CNN 等结构,并将 LSTM 和 CTC 的端对端语音识别技术相结合,使得识别错误率相对下降了 10% (原错误率的 90%)以上。

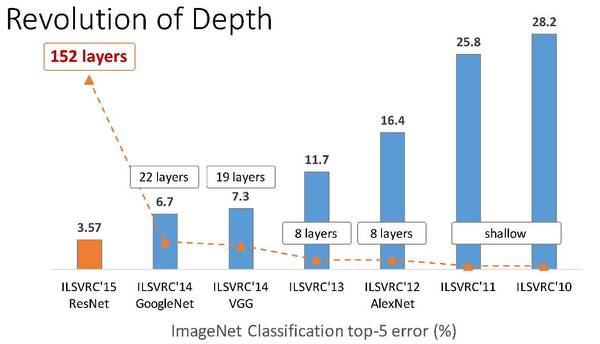

机器之心对百度语音技术部识别技术负责人,同时也是 Deep Speech 中文研发负责人李先刚博士进行了独家专访,李先刚博士详细解读了 Deep CNN 中的各项技术以及研究思路,并表示此次语音识别技术的提升将在接下来用于语音搜索产品。而百度正在努力推进 Deep Speech 3 ,这项研究不排除将会是 Deep Speech 3 的核心组成部分。以下是采访内容: 机器之心:能先大体介绍一下 Deep CNN 吗? 李先刚:百度这次利用深层卷积神经网络技术(Deep CNN)应用于语音识别声学建模中,将其与基于长短时记忆单元(LSTM)和连接时序分类(CTC)的端对端语音识别技术相结合,大幅度提升语音识别产品性能。该技术相较于工业界现有的 CLDNN 结构(CNN+5LSTM+DNN)的语音识别产品技术,错误率相对降低 10% 。该技术借鉴了图像识别在近些年的成果,以及语音与图像在利用 CNN 模型训练的共通性,是在端对端语音识别技术的革新之后取得的新的技术突破。 其实最早 CNN 在语音领域是有应用的,这两年语音研究专注的主要是 RNN ,而图像领域专注的 CNN 。在语音领域的研究者把 LSTM 和 RNN 做的很好之后,发现 CNN 的发展在语音领域是可以借鉴和有所帮助的。 比如从 ImageNet 竞赛中就可以看出深层卷积神经网络方面的进展。这些网络结构有一个明显的发展趋势,就是越来越深的卷积神经网络层级(CNN):从最初的 8 层网络,到 19 层,22 层,乃至 152 层的网络结构。ImageNet竞赛的错误率也从 12 年的 16.4% 逐步降到了 3.57% 。

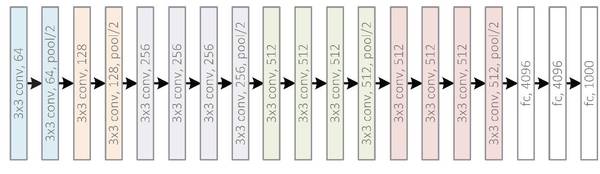

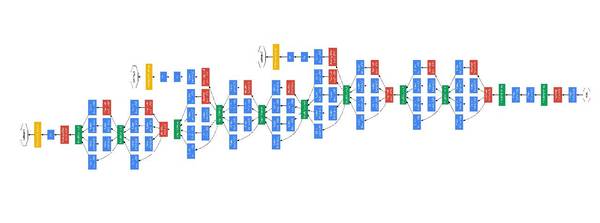

在这个背景下,深层 CNN 成为今年语音领域前沿研究中最火的东西,很多公司都在做这方面研究。而我们这次做 CNN 有个很好的点是有个 baseline ,这是基于 Deep Speech 2 端对端基础上,进一步通过引入 CNN 来实现更好效果,这是我们的研究背景。 在这个情况下,我们做了一些非常有意思的实验和希望得到最好性能的工作。为什么说最好性能呢?因为我们做的工作都是大数据,调参时有上万小时,做产品时甚至有 10 万小时。我们希望通过这些来验证,Deep CNN 是真的可以发挥作用,因为你会发现,现在很多基于数据集做的算法在大数据时可能就没用了,但我们发现它是有用的,在端到端框架下也是有用的,这可能算是我们的一个突破点和贡献。 机器之心:微软最近也公布了一项语音识别的突破,能对比一下这两项研究吗? 李先刚:微软这次研究更加学术,是在一些标准数据库上做的,是一个口语数据库,叫做 switchboard ,数据库只有 2,000 小时。这个工作是微软研究院做的,atv,他们的关注点是基于这样一个数据库最终能做到什么样的性能。而我们的关注点是我们的语音技术能够深入到大家的日常应用中,去把语音识别服务做到更好,我们的数据是数万小时。 机器之心:这项研究涉及的过程和具体技术工作有哪些? 李先刚:在 ImageNet 竞赛得到广泛关注的 DeepCNN 结构,包括 VGGNet ,GoogleNet 和 ResNet 等。其中 ResNet ,可以通过 Residual 连接,训练得到一百多层的 CNN 网络,这样的网络虽然能够显著提升性能,由于其无法实现实时计算,使得其难以在产品模型得到应用。但是我们可以借鉴 Residual 连接的思想,训练一个数 10 层的包含 Residual 连接的 DeepCNN ,以用于工业产品中。

从上至下为 VGGNet 、GoogleNet 和 ResNet 因此,百度做了以下的对比试验:1)HMM 框架中基于 VGGNet 结构的声学模型;2)在 HMM 框架中包含 Residual 连接的 CNN 网络结构的声学模型;3)在 CTC 框架中使用纯 VGGNet 实现端对端建模;4)在 CTC 框架中,在 CLDNN(CNN+5LSTM+DNN)结构中的 CNN 借鉴图像领域的研究成果,尝试 VGGNet ,包含 Residual 连接的深层 CNN 等结构。 (责任编辑:本港台直播) |