|

如果你也对视觉智能研究感兴趣,我们的计算机视觉 API 会对你有帮助。它能从任何图像中提取丰富的信息,并对视觉数据进行分类和处理。你也可以使用我们在GitHub上发布的范例来自己做一个生成视频标题的 App。不妨试试看! 微软计算机视觉 API:https://www.microsoft.com/cognitive-services/en-us/computer-vision-api Github 官网:https://github.com/Microsoft/Cognitive-Samples-VideoFrameAnalysis/ 微软 VideoToText 挑战赛 & MSR-VTT 开源数据库 视频在互联网、广播频道和个人设备上变得越来越常见,促使在大量的应用中,出现了用于分析视频内容语义的先进技术。视频识别一直是几十年来计算机视觉中的绝大难题。此前的研究大部分都着眼于识别预先定义而且非常有限的词汇。 本挑战赛需要再进一步,把目标视频内容转化成一个完整和自然文字句子。

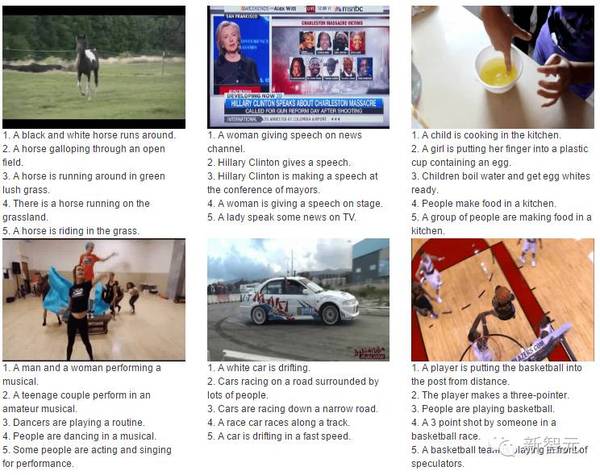

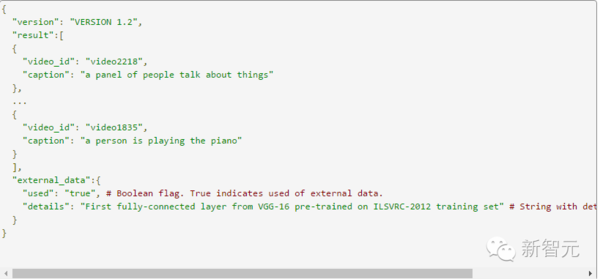

微软将会发布 Video to Text (MSR-VTT),这是一个开源的大规模视频基准,用于实现视频与语言之间的转换(具体时间关注新智元后续报道)。MSR-VTT 数据库包含了 41.2 小时的视频和 200 K 短语,覆盖了最全的种类和最多样化的视觉内容。在句子和词汇上目前做到了最大。 数据库可以被用于训练和评估视频到语言的转换任务,在不远的未来,也可以用于其他一些任务,比如,视频检索、事件监测、视频分类等等。这一挑战赛将允许使用外部数据来训练和挑战算法的参数。 对于有兴趣参赛的读者,下面简单介绍 VideoToText 挑战赛(详细内容可以下载论文查看)。 任务描述 今年的比赛将聚焦于视频到语言的转化任务。给定一个输入视频片段,其目标是自动的生产一个完整的自然语言句子,描述视频中的内容,把视频中的信息提取出来。 参赛者需要根据提供的MSR-VTT数据库(作为训练数据),或者别的任何公共、私人数据开发语言模型,来识别图像或者视频中大量的物体、场景和事件。为了满足评价标准,一个参赛系统至少需要产生关于视频的一个描述。其准确率被用于与人类写成的描述进行比较。 提交样本

评价标准 最后评价的标准将取决于在MSR-VTT测试集上取得的结果,会对多项常用标准进行评价,其中包括BLEU@4, METEOR, ROUGE-L, and CIDEr-D。 此外,竞赛还会加入人为测评。标准如下: 连贯性:判断句子的逻辑和可读性 相关性:句子中有没有包含更加重要和相关的信息 对盲人的帮助性(额外标准):这句子对于盲人理解视频是否有帮助 论文:为用户生成的视频生成标题 作者:Kuo-Hao Zeng, Tseng-Hung Chen, Juan Carlos Niebles, Min Sun 摘要 一个好的视频标题能够简洁明了地描述最显著的特征同时吸引观众的眼球。相比之下,视频描述(video captioning)往往生成的是描述整个视频的句子。尽管自动生成视频的标题十分有用,但受的关注却远不如视频描述。我们结合两种方法,首次实现了自动生成视频标题的任务,这两种方法都是当前最先进的视频描述技术的扩展。 首先,我们使用一个重点检测器(highlight detector)对视频描述生成器进行初始化,让视频描述生成器能够关注重点部分。我们的框架能够同时训练标题生成模型和视频重点定位模型。然后,我们将高度句子多样性引入视频描述生成器,这样生成的标题听上去就多样而且上口。这意味着系统需要大量的句子作为训练数据,学习标题的句子结构。 因此,我们提出了一种全新的句子增强(sentence augmentation)法,使用仅含有句子的样本对其进行训练,这些句子都是之前没有用过的,而且也没有对应的视频。我们收集了一个大规模的 Video Titles in the Wild(VTW)数据集,含有 1.81 万机器从网上自动获得的用户生成的视频和标题。在 VTW 上面,我们的方法持续提高标题预测的准确率,在自动评估和人类评估两方面都取得了最好的成果。最后,我们的句子增强法还超过了 M-VAD 数据集的基准。 【进入新智元公众号,直接在对话框输入“1012”下载论文(附VideoToText挑战赛介绍)】 编译来源:https://www.microsoft.com/en-us/research/bots-generate-video-titles-and-tags-to-bring-ai-researchers-one-step-closer-to-visual-intelligence/

豪华嘉宾阵容,atv,共飨 AI 盛宴

8 大院长齐聚新智元智库院长圆桌论坛 (责任编辑:本港台直播) |