|

这不仅是伦理课的练习题,

许多人都听过那个老笑话:一个新手司机准备接受考官的面试。别的问题答得都非常不错,就剩最后一个问题。考官问他:“ 你在路上开车,忽然间马路左边走出一个人,右边窜出一条狗,请问你应该怎么办? ” 司机想了想说: “ 那我只能往右边开了。” 考官说:“ 很遗憾,这次你没有通过。” 司机很不服气: “ 难不成要我撞人? ” 考官回答:“ 你应该急刹车。” 虽然是笑话,但它也反映出了一些有意思的东西:开车这件事,不光是个技术活,也涉及我们的价值观。比如,对于人类来说,做出 “ 人比狗重要 ” 的判断非常简单,几乎是一种本能。不过,要是我们把情况设置的再复杂一点,直播,比如如果一边是三个在马路上打闹的熊孩子,另一边是一个风烛残年的老人。又该如何?这个答案可就难说了。 对人脑来说尚且如此,对于电脑 —— 尤其是要负责自动驾驶的 AI 来说,这个问题就更复杂了。但这又是十分必要的:许多紧急避险的处理都会涉及道德和伦理判断,如果忽视了这些,那么自动驾驶汽车可能会在危险来临时做出最糟糕的决定。 MIT 目前为解决这些问题提供了一个方案:它设置了一个开放的 “ 道德机制 ” 网页,向网民征求自动驾驶汽车在类似的 “ 道德困境 ” 中的处理方式。(你可以点击 给出你自己的答案:) 内容很简单,你会看到类似于像下图一样的选择题:

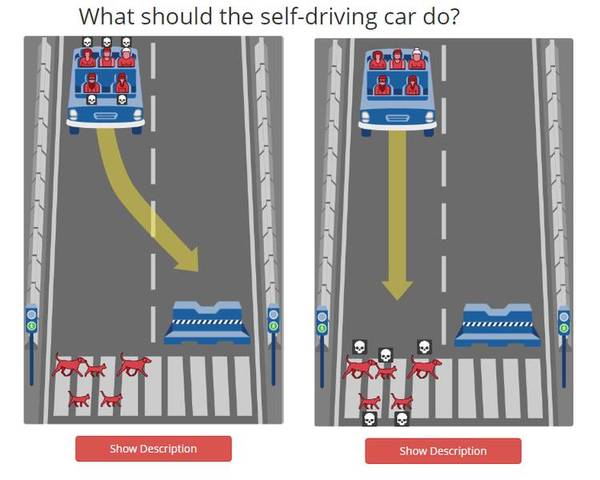

左边的斑马线上有五条狗,右边是一个水泥墩子。如果径直往前开,五条狗会被撞死。但如果绕行别的车道,则可能会撞到水泥墩子上从而使得车上乘客陷入生命危险,你会怎么做?

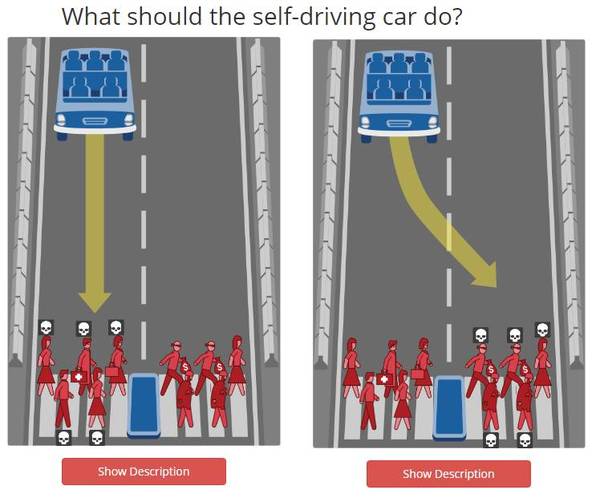

斑马线上有两群人,左边衣冠楚楚,有一个还是救死扶伤的医生。右边则有两个看上去像小偷的家伙,这个时候你会改变车道吗?

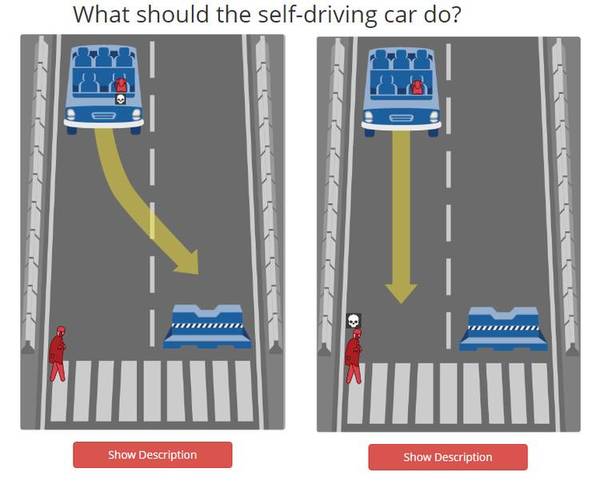

情况非常多种,有一些情况可能你根本没有想过。比如这种情况:一边是行人,一边是会让车毁人亡的水泥墩。只不过这一次,行人是一个衣衫褴褛的流浪汉,而自动驾驶汽车上的乘客是一只狗。那么,自动汽车是应该以保护人的生命为第一,还是以保护乘客的生命(尽管是条狗)为第一呢? 在你做完了问卷之后,你可以看其他人的答案。我看了一下,目前大多数人的观点是:在多数和少数人中间,倾向于保护多数人的生命;在保护乘客还是保护行人中间倾向于中立;尽量避免刻意的违反交通规则和变道(即使可能会有一些好处);在人群的类别中,多数人更倾向于保护年轻人、女性、社会价值高的人群。最后一点是,在胖人和身材健美的人中间,大家更倾向于保护身材健美的人。(知道减肥的好处了吧) 除了这些以外,你可以通过网站提供的工具设计其他可能的选择题。MIT 的设计者表示:这个调查并非直接决定未来自动驾驶汽车的行为,开奖,但是它确实可以作为未来 AI 设计者在处理类似问题时的参考。这也告诉我们,即便是一个小小的自动功能,都可能牵涉到非常严肃的道德悖论。 本文摘选自PingWest品玩,未经许可禁止转载

回复你感兴趣的关键词 (责任编辑:本港台直播) |