|

智东西(公众号:zhidxcom) 编 | 海中天 导语:2016年虽然AI取得了极大进步,但是仍然存在一些滥用误用的现象,甚至曝露出一些严重的问题,特斯拉车祸说明系统不完美,利用AI预测犯罪可能与种族歧视高度关联……这些问题我们应该警惕。 去年AI开始复兴,无人驾驶技术不断进步,语音识别走向完善,AI在围棋上一展雄风,所有这些都说明机器已经相当强大。 在AI取得成功的同时,我们也要该留意它所犯的错误,以及何时犯了错,避免未来造成恶劣影响。最近,路易斯维尔大学网络安全实验室(Cybersecurity Lab)主管Roman Yampolskiy发布一份报告,列出了AI历史上出现的一些错误,他认为,错误是AI系统在学习阶段和执行阶段犯下的。 TechRepublic整理出2016年AI行业犯下的10大错误,这些错误有一些来自Roman Yampolskiy的报告,还参考了其它AI专家的意见。 1、用AI预测未来犯罪 Northpointe公司开发了一套AI系统,它可以预测被指控罪犯再次违法的概率。这套算法遭到指责,它可能存在种族歧视,与其它种族相比,黑人未来犯罪的机率更高,威胁性更大。还有一些媒体指出,不论种族如何,Northpointe软件在一般情况下都无法准确预测。 2、在视频游戏中,非玩家控制的角色制作武器,超出了创作者的设计范围 今年6月,AI视频游戏《Elite: Dangerous 》出现一些怪事,这些怪事超出了创作者的预料:AI可以制作超级武器,它的攻击范围不属于游戏的设计范畴。游戏网站评论说:“玩家可能会被拖入战斗,敌方的战舰装备了超级超大的武器,瞬间就可以将他们切成碎片。”后来,游戏开发者将这些强大的武器删除。 3、机器人让小孩受伤 Knightscope制作了所谓的“打击犯罪机器人”,今年7月,机器人在硅谷商场撞向小孩,导致16个月大的小孩受伤。《洛杉矶时报》引用该公司的话称,这是一件“奇怪的事故”。 4、特斯拉Autopilot导致车主死亡 Joshua Brown驾驶特斯拉汽车在路上行驶,当时他启动了Autopilot功能,结果汽车在佛罗里达高速公路与挂有拖车的卡车相撞,这是Autopilot第一次造成车主。事故发生之后,特斯拉对Autopilot进行升级,马斯克声称该软件本来应该可以避免碰撞。Autopilot还在中国造成伤亡事故,虽然事故与AI系统并无直接关系。 5、微软聊天机器人Tay发表种族主义、性别歧视言论,侮辱同性恋 微软曾经在Twitter推出聊天机器人Tay.ai,本意是想与年轻用户建立联系。Tay是以十几岁的女孩作为原型设计的,结果她变成了推崇希特勒、抨击女权主义的恶魔;刚刚上线一天就变成这样。微软将Tay从社交媒体平台撤下,atv,还说要对算法进行调整。

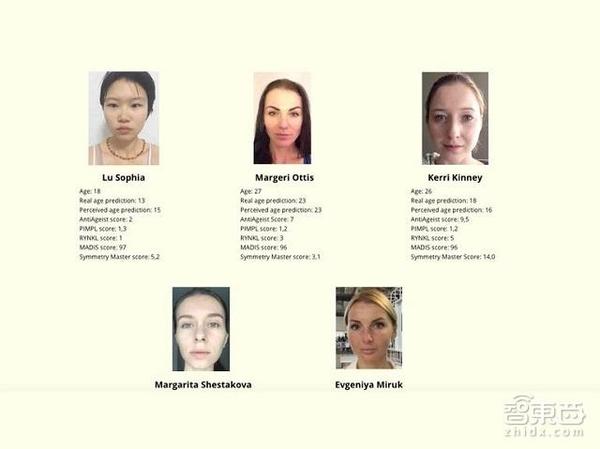

AI挑选出的选美赢家 6、AI成为选美比赛的评委,结果导致种族歧视 在第一届由AI担任评委的国际选美比赛中,机器人小组对选手的脸进行评判,算法可以精准评估各项标准,这些标准与人类对美、健康的感知联系在一起。由于AI没有经历过多样化训练,最终比赛选出来的赢家全部是白人。Yampolskiy评价说:“美成为了模式识别器。” 7、《口袋妖怪Go》将玩家留在白人社区 7月份,《口袋妖怪Go》迅速走红,一些用户注意到,在主要的黑人社区缺少玩游戏的场所。Mint 首席数据官 Anu Tewary 认为,之所以出现这样的事情,主要是因为算法制作者没有进行多样化训练,他们没有在这些社区投入时间。 8、谷歌AI系统AlphaGo在围棋比赛第四局输给了李世石 2016年3月,AlphaGo在5个回合的比赛中战胜了李世石,他曾经18次成为围棋世界冠军。虽然AI算法赢得对决,但是李世石赢下一局意味着AI算法仍然不是完美的。 新南威尔斯大学的人工智能教授 Toby Walsh认为:“看起来李世石找到了蒙特卡洛树搜索(MCTS)的弱点。”虽然这次失利可以视为AI的缺陷,但是Yampolskiy认为这种失误在允许范围之内。

9、中国面部识别研究可以预测犯罪,但是存在种族歧视 (责任编辑:本港台直播) |