|

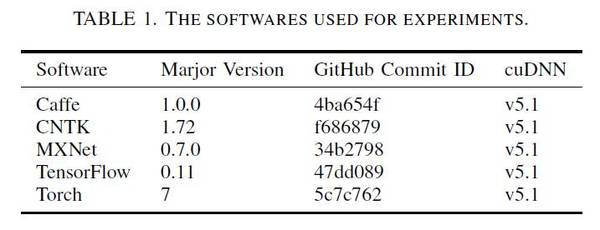

2016 年 8 月,香港浸会大学褚晓文团队的研究者发表了一篇论文,,最近该论文更新了第六版。本次的主要更新包括:(1)软件版本更新;(2)加入 MXNet;(3)剔除了假数据,还使用了 MNIST and Cifar10;(4)一机多卡的测试。

摘要 深度学习已被证明是一种可成功用于许多任务的机器学习方法,而且它的广泛流行也将很多开源的深度学习软件工具开放给了公众。训练一个深度网络往往是一个非常耗时的过程。为了解决深度学习中巨大的计算难题,许多工具利用了多核 CPU 和超多核 GPU 这样的硬件特性来缩短训练时间。但是,在不同的硬件平台上训练不同类型的深度网络时,不同的工具会有不同的特性和运行性能,这让终端用户难以选择出合适的软件和硬件搭配。在这篇论文中,j2直播,我们的目标是对当前最先进的 GPU 加速的深度学习软件工具(包括:Caffe, CNTK, TensorFlow 和 Torch)进行比较研究。我们在两种 CPU 平台和三种 GPU 平台上使用三种流行的神经网络来评测了这些工具的运行性能。我们做出了两方面的贡献。第一,对于深度学习终端用户,我们的基准评测结果可用于指导合适的软件工具和硬件平台的选择。第二,对于深度学习软件开发者,atv,我们的深度分析为进一步优化训练的性能指出了可能的方向。 实验数据

评测软件版本

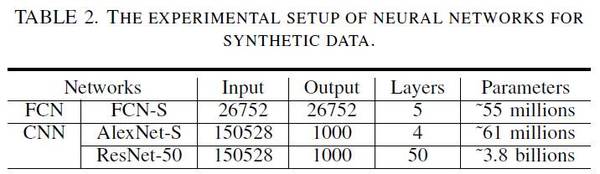

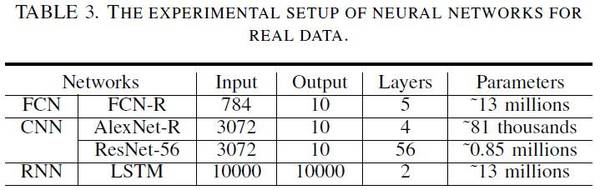

评测中的神经网络设置

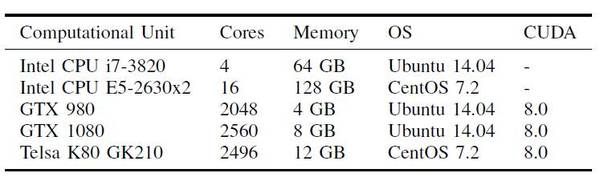

评测硬件配置

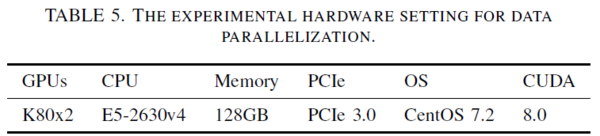

评测硬件配置——并行数据

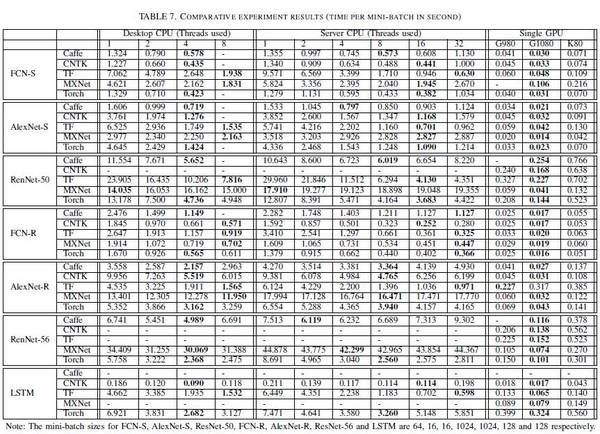

对比结果(每个 mini-batch 的时间/秒;其中加粗的为最优)

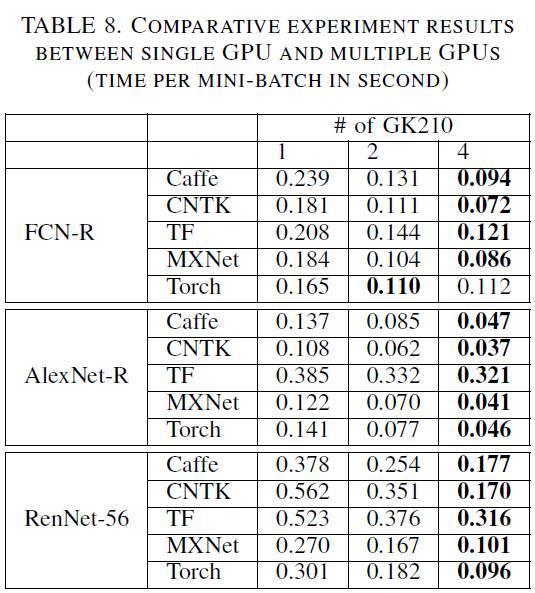

单GPU-多GPU对比 结论 本研究旨在对比现代深度学习软件工具的运行性能,测试它们在不同类型的神经网络和不同的硬件平台上的执行效率。我们的实验结果表明,目前所有经过测试的工具都可以很好地利用 GPU,比使用 CPU 的竞争对手有着很大优势。然而,没有任何一个工具可以在所有方面胜过其他软件工具,这意味着也许存在进一步优化性能的方向。 在未来的研究中,首先,我们会将更多的深度学习软件工具(如百度的 Paddle)和硬件平台(如 AMD 的 GPU 和英特尔至强 Phi)纳入这项基准研究。其次,我们计划评估在高性能 GPU 集群上这些工具的可扩展性。 论文链接:https://arxiv.org/pdf/1608.07249v6.pdf ©本文为机器之心编译,转载请联系本公众号获得授权。 ?------------------------------------------------ 加入机器之心(全职记者/实习生):[email protected] 投稿或寻求报道:[email protected] 广告&商务合作:[email protected] (责任编辑:本港台直播) |