|

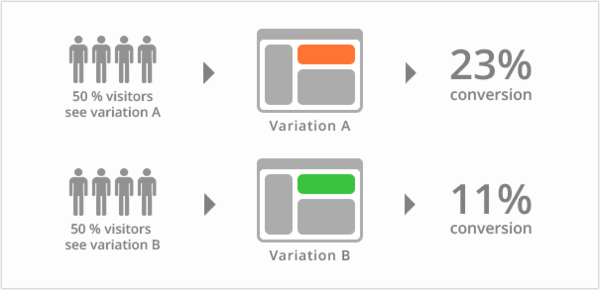

A/B 分类测试 A/B分类测试使得网站可以通过比较同一网页的不同设计,开奖,来决定其中哪些设计将产生最好的结果。在A/B测试中用到的指标是微观和宏观的转化率。随着那些不需要太多开发协助和技术资源就能运作A/B测试的工具的出现,A/B测试已经变得愈加常见。这个方法本在市场营销从业者中有着很稳的立脚点,而因为成本相对较低,它也正在越来越广泛地被用户体验设计师们所运用。许多大型电子商务网站如谷歌及亚马逊都以“总在测试中”而著称--他们在任何适合都同时进行着多组A/B测试。

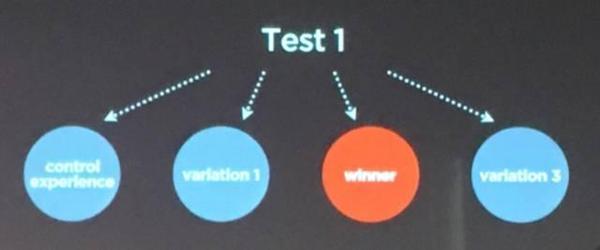

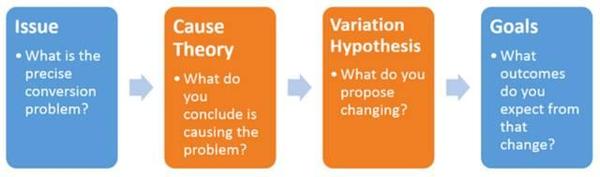

(来自Netflix分享ppt) 无用输入,无用输出(GIGO) 使用得恰当时,A/B测试是一个非常强大的工具。然而以下三种情形下的A/B测试还是会有潜在的问题: 1)当所要测试的设计元素并没有很好地提现设计意图。 糟糕的设计会导致糟糕的转换率 - 这很显而易见。但是,每个设计都是一个产品概念的后续执行,因而通过设计的实施来评判一个产品概念本身的优劣是很可笑的。通常要经过许多次设计尝试才能充分地体现出真正的设计意图。 比如说,你可以认为理论来说,增加对某一选项的说明会增加其被选择的可能性,然而如果这条描述表达得像一则广告,用户就可能会无视。这个增加选项的说明的设计意图是对的,但其表达形式却是错的。因此设计意图和设计结果的偏差可能会是致命的。 当设计元素本身并不能告诉你问题的源头在哪。对问题起因的错误推测,也会让你在错误的设计元素上浪费时间,因为该元素却并非是该问题背后真正的原因。即便修改这个设计元素也不能真正解决问题,因为你的切入点一开始就错了。比如,你可能猜测一个贷款申请提交转化率低是因为流程的页面太多了,所以你把它浓缩到一个页面里,但是你仍看不到任何转化率的提升。你忽略的是,用户真正的问题是找不到贷款利率,而他们点进申请页面其实是为了找贷款利率。 2)当设计只是设计者的主观猜想。 使用A/B测试时你只能从已提供的设计选项中找到最佳的那个。如果这些选项是基于主观经验和意见的话,谁又能说这个测试包含了最优的设计呢? 3)这些A/B测试实验过程当中的瑕疵可以通过用户研究来减少。 即使只实施了些许的用户研究,我们仍能获取一些极其宝贵的有关于转化率问题的潜在原因的线索。 发现真正原因,定义更好的设计 发现(造成转化率低的)真正原因,定义更好的(用于测试的)设计。 “实验可以证实一个理论,但实验永远无法创造出一个理论。 ” - 爱因斯坦 要保证A/B测试执行得好,需要定义以下这几步:

你可以先集中全部精力建立一套致因体系,并罗列设计元素的可能性,然后用A/B方法把他们全部测试一遍:这是最直接了当却不免有一些鲁莽的方法。不经深思熟虑的 A/B测试等同于把想法往墙上扔然后看哪个能黏住。不幸的是,你做不起这样的测试:这样大规模地测试会增大用户放弃操作的几率,并且使总体验变糟糕。当你等着从大量A/B测试像抽中彩票一样找到最好的方案,用户可能已经转而使用了他们第二选择的产品。他们可能最终认定你的网站是失败的,以后再也不来了。你需要缩小假设的数量范围,并且小心谨慎、高效地部署你的A/B测试;为达到此目的,我们推荐使用用户研究的方法。 提升最优化测试的用户体验研究方法

1)定义用户意图和可能反对的理由 理解人们为何访问、是否能成功访问、和他们为何会离开,是相当重要的。如果你错误地假设了人们访问网站的原因,那么你的起因理论和设计假设将不能够反应用户感知该环境的真实情况。没有做过调查就对用户离开的原因做假设是很危险的。举个例子,假定你假设访问者没有做意想中的操作(买单)是因为价格太高,你于是将价格降低,边际利润就受到了打击。如果人们真正不买账的原因不是价格,而是他们不理解你提供的服务所解决的需求是什么,那么你就大错特错了。 让我们来看看Netflix是怎么做的: (责任编辑:本港台直播) |