|

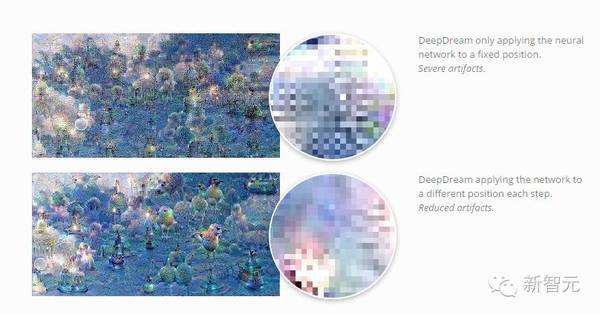

但是,在尺寸调整卷积层中调整去卷积层能让这些“棋盘效应”消失。谷歌大脑团队在接下来的论文中将会用更加连贯的实验和更先进的结果,展示这种技术的优势。(我们选择提前单独公开这一技术,是因为它值得有更多细节的讨论,也因为它包含了多篇论文的结果。) 梯度中的 Artifacts 不管什么时候,只要计算一个卷积层的梯度,我们就要在反馈通道中进行一次去卷积(转置卷积,transposed convolution)。这一过程导致了在梯度中会产生棋盘模式,正如我们使用去卷积生成图像遇到的问题一样。 在特征可视化领域,图像模型梯度中“噪音”的频繁出现是一个巨大的挑战。从某种程度上来说,特征可视化的方法必须要对这些噪音做出补偿。 例如,DeepDream 似乎会在不同的 Artifacts 间引发破坏性的干扰,比如,在同时对多个特征 ,或者在多个偏移(offsets)与尺度(scales)中进行优化的时候。尤其值得一提的是,不同偏移中优化时产生的“抖动”(jitter),抵消了一些棋盘效应。 (虽然大多数的Artifacts是我们标准的棋盘模型,但是其他则是无组织的高频率模型。我相信这是由于最大池化造成的。Henaff 和 Simoncelli 在2015年的论文中曾提出,高频率的Artifacts与最大池化有关。)

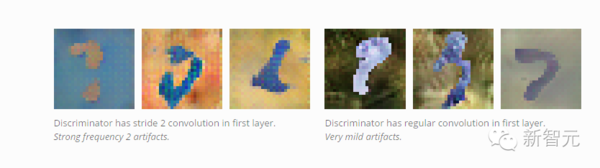

在特征可视化上,更多最新的研究明确地识别和补偿这些高频率的梯度组建。一个问题是,有没有更好的神经网络架构,可以让这些工作变成“非必要”选项。 这些梯度Artifacts 影响了GAN?如果梯度 Artifacts 能影响一个被优化的图像,在特征可视化中,这些图像基于一个神经网络梯度,我们还期待,也许它也会影响由生成器参数化的图像集,因为它们都是在GAN中通过鉴别器进行优化。 我们发现,在一些情况下,上述情况确实会发生。当生成器既不偏向或反对棋盘模型,辨别器中的大步卷积就会引发上述情况。现在还不清楚这些梯度Artifacts会不会带来更加宽泛的影响。一个思路是,一些神经元将会回相邻的神经元中多次获得梯度,而且是任意的。同等的,网络也会偏重于输入中的一些像素,具体原因还不清楚。

似乎,一些像素会比其他像素更严重地影响输出这一事实,会夸大了对抗性反样本的作用。因为派生只聚焦于小量的像素,这些像素中一小部分的干扰可能会有大的影响。我们还没有研究这一点。 结论 用反卷积的常规方法生成图像(尽管这种方法非常成功),在概念上仍然存在一些非常简单的问题,使得在生成的图像中出现棋盘效应。使用一种自然的替代方法,避免掉这些问题,可以消除棋盘效应。(一些研究表明,标准的大步卷积层可能也有问题)。 这对我们来说是一个激动人心的机会。它表明,可以在神经网络架构中通过谨慎地思考,寻找一种低门槛的方法,这种方法能让我们找到清晰的解决问题的方法。 我们提供了一个易用的解决方案,提高了用神经网络生成图像的质量。我们期待看到这种方法会被怎样使用,以及它是否能对音频之类的领域有所帮助,这类领域中的高频伪影是尤其棘手的问题。 【译注:原文标题是 Deconvolution and Checkerboard Artifacts,本文中"Checkerboard Artifact "翻译成“棋盘效应”,“Artifact”视情况翻译成“棋盘效应”或“伪影”。】 编译来源: 参考文献: Dong, C., Loy, C.C., He, K. and Tang, X., 2014. Image super-resolution using deep convolutional networks.arXiv preprint arXiv:1501.00092. Dumoulin, V., Belghazi, I., Poole, B., Lamb, A., Arjovsky, M., Mastropietro, O. and Courville, A., 2016.Adversarially Learned Inference. arXiv preprint arXiv:1606.00704. Dumoulin, V. and Visin, F., 2016. A guide to convolution arithmetic for deep learning. arXiv preprint arXiv:1603.07285. Donahue, J., Krähenbühl, P. and Darrell, T., 2016. Adversarial Feature Learning. arXiv preprint arXiv:1605.09782. Gauthier, J., 2015. Conditional generative adversarial networks for convolutional face generation. Technical report. Hénaff, O. J., & Simoncelli, E. P. (2015). Geodesics of learned representations. arXiv preprint arXiv:1511.06394. Johnson, J., Alahi, A. and Fei-Fei, L., 2016. Perceptual losses for real-time style transfer and super-resolution. arXiv preprint arXiv:1603.08155. Mordvintsev, A., Olah, C., & Tyka, M. (2015). Inceptionism: Going deeper into neural networks. Google Research Blog. Mordvintsev, A., 2016. DeepDreaming with TensorFlow. Github. Radford, A., Metz, L. and Chintala, S., 2015. Unsupervised representation learning with deep convolutional generative adversarial networks. arXiv preprint arXiv:1511.06434. Salimans, T., Goodfellow, I., Zaremba, W., Cheung, V., Radford, A. and Chen, X., 2016. Improved techniques for training GANs. arXiv preprint arXiv:1606.03498. (责任编辑:本港台直播) |