|

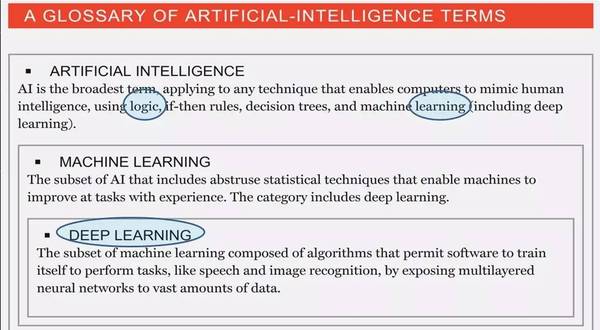

【编者按】:10月18日,微软人工智能首席科学家邓力在北京出席世界人工智能大会并发表演讲,回顾了最近十年AI的发展,包括难点和突破,提出了值得特别关注的动向,其中之一是美国白宫最近发布的人工智能报告,单独把deep learning列了一个标题。 今天在这里向大家介绍微软的一些深度学习研究,也感谢组委会专门给我这个题目,叫我讲一下十年深度学习的历史。正像你们刚才听到(加拿大蒙特利尔大学)Yoshua Bengio教授讲的一样,微软在深度学习的开始阶段就做了非常大的启动。今天继续向大家介绍一下在这之后我们很多的进展,最后分享一下对未来的展望。 今天的观众有相当多的投资人士以及技术人士,从业界来的。所以我向大家介绍两礼拜前《财富》杂志的一篇文章,讲了深度学习一部分的历史。趁此机会也向大家介绍这篇杂志文章里面给的深度学习的定义。从技术的角度从科学的角度来讲,我想再补充一些材料,使得大家对深度学习跟人工智能的看法有一些更深入的了解。 这是《财富》杂志所讲的定义。

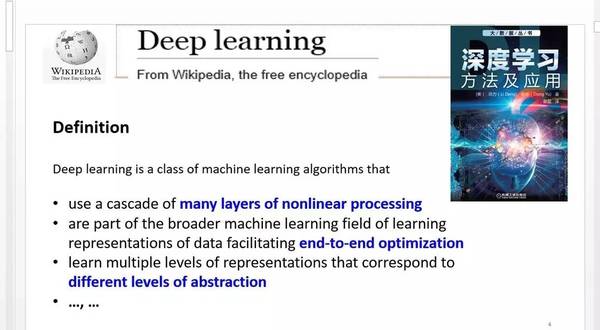

这个定义基本是准确的。比如说定义人工智能,它包括一大串的技术,包括逻辑推理技术,包括机器学习技术,在机器学习的技术又包括深度学习的技术,在这里面主要的一块是机器学习。机器学习所解决的问题,是要用数据跟统计的方法或者神经网络的方法来解决现实生活中的任务(tasks)。在机器学习里面最重要的一块是深度学习,它也包括一大串的技术加上应用。虽然在这个文章里面只讲语音应用和图像应用,实际上还有一大串自然语言处理的应用。在这个演讲里面,我把这些新的应用和新的技术向大家介绍一下。 刚才《财富》杂志的文章讲的深度学习还是从商业的方面来讲,大家能够看得懂。要是看Wikipedia,它讲的深度学习的定义比刚才的文章更深一点。我向大家介绍一下Wikipedia的定义。

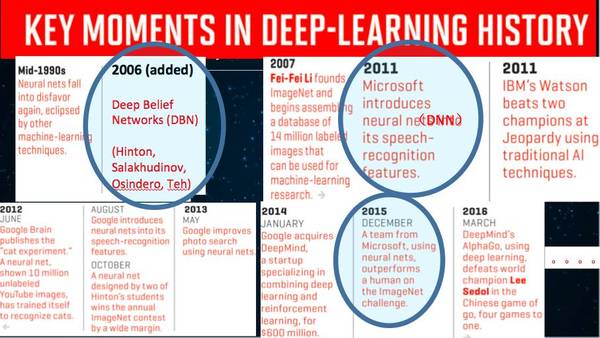

深度学习有三个要点:第一,这是一般的定义,不单单是神经网络,它包括各种各样的其它方法。它的精髓——好几个不同层次的非线性变换。第二,因为有好多层次,就出来了一个非常重要的问题——怎么样来优化这个多层次的系统。在浅层学习的模型里面,这个优化问题不是那么严重,因为比较容易优化。可一旦有了深层之后,这个优化就成为一个非常难的问题。这也是其中很大的一个原因,导致深度神经网络在1980和1990年代没能产生很大的影响。当时数据不够,计算能力也不够,而且当时算法也不够。差不多十年之前端到端的优化学习问题开始得到了解决——并不是说理论上得到解决,我只是说在实际算法上得到了解决。 第三,这点更重要,尤其在语音识别和图像识别之外的更重要的认知领域的应用。在这种更高层次的应用情况下,深度学习更重要的是,因为它有不同层次的表达,它就能够把抽象的概念进行层次化的表征。在我下面讲的应用中我想特别是把第三个要点向大家描述得更深刻一点。头两个特性一般是大家在深度学习上看得比较清楚的,而且很多的文献讲得比较多。第三点的抽象性确实是深度学习的最重要的精华。 关于深度学习十年的历史,我从《财富》杂志的文章抽取了一张表。理论上开创性的工作,神经网络的研究,可以追溯到好几十年前。我只讲讲近期的历史。1990年代第二次人工智能浪潮,主要也是由神经网络突破引起的,当时的突破只是在概念上的突破,神经网络的一些算法成为非常主流的算法,一直延伸到现在。但是应用上的大规模突破只是到最近Yoshua Bengio教授讲的前五年之前才开始。

这是一篇非常重要的文章,多伦多大学差不多20年前发表的文章“wake sleep”算法。

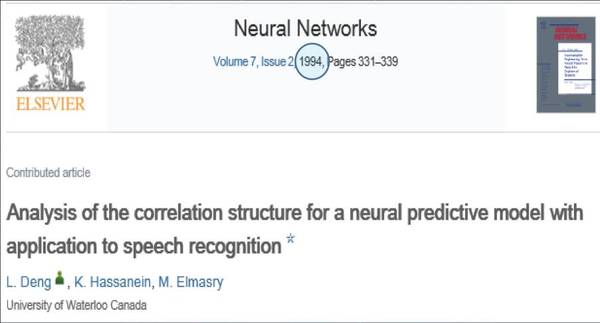

怎么让神经网络做非监督的学习?1990年代中,第二次神经网络热潮往下降,一直做不起来。大家往深层次的模式来想,那时候这种方法也没有成功,但对我有了非常大的启发。当时我在加拿大任教做时程上的深层次的神经网络研究,在1994年写了这篇文章。我当时做语音识别做了相当长的时间,一直比不上统计概率的模型。我跟研究生和同事写的这篇文章,做了非常强的分析,跟Yoshua Bengio一篇文章有点类似,当然,随着你的网络层次变得非常深,学习的困难就变得越来越大。当时用到语音识别上面没成功。但给我们很大的启发,关于到底要往哪个方向走。这是20年前的事情。在这之后,因为大家都认识到神经网络成功的机会不是很大,更重要的原因是当时统计的模型发展得非常快,另外还有机器学习的模型在那时候实际应用的效果远远超过神经网络,于是神经网络就慢慢像刚才Yoshua Bengio教授讲的那样削弱了。

|